Le risque opérationnel souffre de deux maux majeurs qui rendent difficile sa prise en considération dans le monde bancaire. Le premier de ces maux est l’absence d’arbitrage évident dans le choix des options réglementaires qui se présente à un établissement soumis à Bâle II. Si l’incitation des établissements à appliquer des méthodes internes pour la mesure de leurs risques est évidente pour le crédit et le marché, il n’en va pas de même pour le risque opérationnel. Une hésitation peut subsister entre la mise en place de modèles sophistiqués d’évaluation ou de simples méthodes forfaitaires. En effet, dans le cas des méthodes standard, le PNB d’une banque (lissé sur 3 ans) est corrélé positivement à son exigence en fonds propres réglementaires (EFP). Dans le cas d’un environnement conjoncturel durablement difficile, l’incitation à déployer des techniques avancées de mesure du risque pourrait devenir alors quasi nulle, puisque le faible niveau du PNB induit un niveau également réduit d’EFP. Se pose alors la question embarrassante de savoir si l’exercice même de quantification présente un intérêt ou non.

L’efficacité du dispositif de maîtrise du risque mis en cause

Le second mal dont souffre le risque opérationnel est plus délicat à percevoir, mais il est pourtant crucial : il existe un effet limité voire réducteur d’un dispositif avancé de mesure, de suivi et de gestion du risque opérationnel lorsque l’on parle d’appétence au risque. En effet, et c’est le postulat de départ, l’efficacité d’un dispositif de maîtrise du risque opérationnel n’est par essence efficace que sur les risques «

Un effet limité sur le niveau d’exigence en fonds propres

La qualité de gestion du risque opérationnel (efficacité des contrôles, amélioration de la mesure, de la cartographie des risques…) n’a en réalité qu’un effet très limité sur le niveau d’exigence en fonds propres réglementaires. Compte tenu de cette réalité, les autorités de tutelle ont naturellement accentué leur pression sur une couverture adéquate des pertes extrêmes pour les établissements. Dans le cas français, certaines décisions ont notamment démontré la relative insensibilité de l’Autorité française aux efforts de maîtrise des risques opérationnels lorsqu’il s’agit de pertes extrêmes, en particulier pour les activités de banque d’investissement (exemple du « rogue trading »).

De ces maux découle une série de difficultés pour les établissements à exploiter les mesures qu’ils peuvent faire de leur risque opérationnel et surtout à définir leur propre capacité de résilience à ce risque si particulier.

Se poser la question de sa propre survie aux risques extrêmes

Tout ceci n’incite donc pas à considérer la gestion du risque opérationnel comme une dimension a priori stratégique et prospective. D’ailleurs, poser la question de l’appétence au risque opérationnel d’une banque, c’est se heurter aux incohérences même que la mesure de ce risque porte en son sein. Pourtant la problématique essentielle est bien là : est-il possible et souhaitable de déterminer précisément la capacité de résilience d’un établissement dans des contextes économiques différents (standard ou extrêmes, bas de cycle ou reprise économique, etc.) ?

Si l’on considère que oui, alors une démarche d’appétit pour le

- quelle est la perte maximale potentielle à laquelle je suis exposé aujourd’hui ?

- quel niveau de perte peut remettre en question la survie de mon établissement ?

- quel plan d’action mettre en place si un tel événement de perte se matérialisait ?

Mesurer son appétit pour le risque opérationnel : une démarche atypique

L’appétit pour le risque opérationnel relève donc d’une démarche qui se distingue de celles généralement suivies pour les autres risques. Elle ne cherche pas l’optimisation et l’amélioration, elle relève avant tout de la mise en garde. Les objectifs assignés diffèrent donc de ceux rencontrés habituellement. De façon volontairement simplificatrice, la construction d’une démarche d’appétit pour le risque appliquée au risque opérationnel peut se résumer en trois étapes.

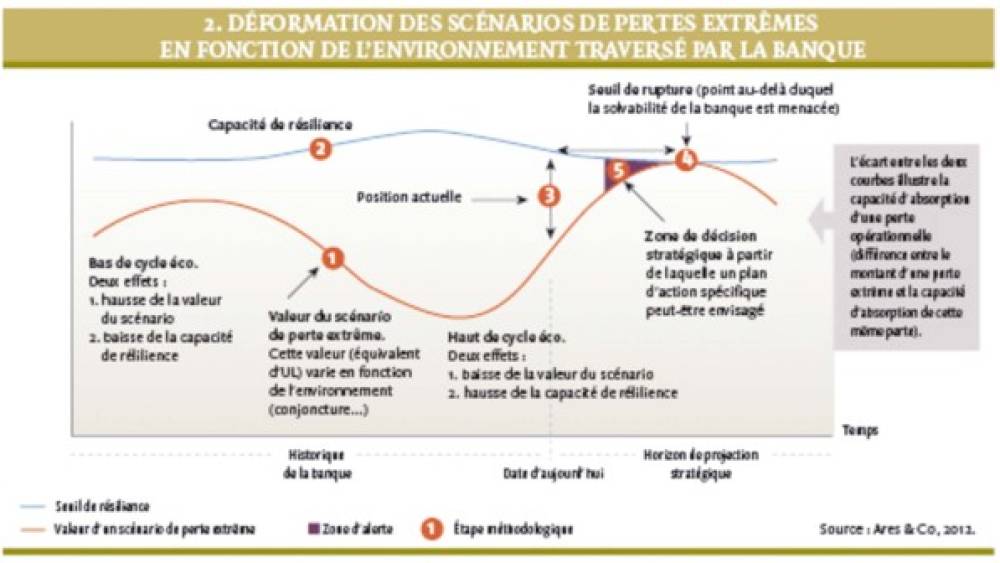

1. Déterminer sa propre capacité de résistance

Cette étape a pour but de mesurer les seuils de résistance aux pertes extrêmes,ces dernières pouvant constituer une menace pour la survie d’un établissement à un moment donné de son histoire. À l’instar du montant d’un scénario extrême (UL – Unexpected Loss), la capacité de résistance d’une banque évolue en fonction de la situation dans laquelle elle se trouve : sa résistance est plus faible en période de crise, par exemple. En revanche, et la nuance est d’importance, à la différence du montant d’UL, il est possible d’agir sur la courbe de résistance du groupe en mettant en place des actions appropriées et spécifiques.

2. Savoir se situer et donc se positionner correctement

L’objectif est de déterminer la position actuelle d’un établissement sur sa courbe de résistance et face au montant potentiel d’un scénario de pertes extrêmes. Ce positionnement se fait évidemment en fonction de la situation sur les marchés financiers (confiance, volatilité, etc.) et de l’état de la conjoncture économique à date. Plus concrètement, il s’agit de mesurer la capacité réelle de résistance d’un établissement pour une date donnée, c'est-à-dire l’écart entre son seuil de résistance et le montant actualisé de son scénario catastrophe.

3. Mesurer l’impossible

Si une banque connait à la fois sa capacité de résistance et le risque potentiel extrême auquel elle pourrait se voir confrontée, elle peut alors déterminer son seuil de rupture. Ce dernier est défini comme la situation au cours de laquelle la courbe de résistance d’un établissement croise sa courbe d’UL (voir Schéma 2). L’atteinte de ce seuil peut entraîner une remise en question des activités du groupe, puisque ce dernier ne peut théoriquement plus faire face, seul, à l’absorption d’un choc opérationnel extrême. L’objectif est bien entendu de ne jamais atteindre ce seuil.

Et ensuite, que peut-on faire ?

Il faut bien le reconnaitre, et c’est bien là toute la difficulté et donc l’ambigüité du risque opérationnel : la prise de mesures

D’abord, les outils à disposition n’existent théoriquement pas sur les pertes extrêmes. Réduire les capacités d’octroi ou augmenter l’efficacité d’un recouvrement restent des armes utiles pour la gestion du risque de crédit, mais leurs équivalents n’existent pas pour le risque opérationnel, à tout le moins pour les risques extrêmes.

À quoi bon vouloir tenter de gérer ou couvrir les queues de distribution si cela reste sans effet ? Les établissements sont d’autant plus réticents à cet exercice que les exigences relativement nouvelles en fonds propres pèsent lourd sur certaines activités (activités de marché, courtages…). Ensuite, l’exercice de couverture a évidemment un coût, déjà intégré et répercuté dans les marges opérationnelles si l’on en croit les établissements. Enfin, les problématiques de solvabilité et de liquidité de ces derniers mois occultent quelque peu ces questions pourtant d’actualité (UBS en 2011).

Étudier des voies complémentaires

Plusieurs voies, souvent complémentaires, doivent néanmoins être étudiées. L’incitation aux méthodes internes de mesure du risque opérationnel en est une et elle doit d’urgence être renforcée. L’idée de pénaliser davantage les établissements ayant recours aux méthodes « standard » ne serait alors plus à exclure – revue des pondérations forfaitaires par le régulateur, par exemple. Cela conduirait aussi à une plus grande maturité générale dans le traitement de ce risque.

Une autre voie serait d’accepter l’idée qu’un établissement seul ne peut faire face à des événements de nature exogène, en particulier dans certaines circonstances connues ou anticipées par avance. Une réponse de Place, donc de nature systémique, pourrait éventuellement être étudiée, en vue de mutualiser ces risques entre les différents acteurs tout en impliquant davantage les autorités de contrôle. Le tout dans un format à définir, mais axé principalement sur un financement commun (création d’un fond dédié par exemple). D’autres alternatives restent encore possibles : couverture de nature assurantielle, réduction voire suppression temporaire d’activités lorsque des seuils internes sont atteints, etc.

Une prise de conscience collective est nécessaire

Pour autant, le choix de telle ou telle stratégie de couverture de ces risques extrêmes (potentiellement systémiques) ne peut se poser sans une prise de conscience collective des enjeux associés. Le bénéfice d’une telle réflexion permettrait d’ailleurs de mieux positionner le risque opérationnel par rapport aux autres risques, à ne pas sous-estimer sa place dans le pilotage stratégique de la banque. Chaque établissement serait alors à même de définir individuellement son propre appétit aux risques de nature opérationnelle et d’inclure les résultats dans le pilotage de son « risk reward ». Un choix efficace et collectivement partagé serait alors possible dans le format de réponse à donner. Compte tenu de l’hétérogénéité des pratiques actuelles, de l’absence d’une incitation prudentielle forte sur ce sujet, et d’un contexte économique défavorable (centré sur les risques de liquidité et de dégradation du coût du risque), l’horizon de réponse n’est pas envisageable avant