La crise financière, depuis 2008, illustre à quel point banquiers et investisseurs doivent avoir un dispositif d’analyse-crédit aussi développé que possible. Force est de constater, si l’on prend pour exemple

Lehman n’est pas le seul exemple. Les faillites d’Enron, fin 2001, de Parmalat, en 2003, et plus récemment de

Les signes avant-coureurs

Premier signe important, la révélation d’incohérences dans les chiffres publiés ou communiqués par une société et donc l’existence d’un doute sur la sincérité de sa comptabilité mettent indirectement en cause toute analyse qui aurait été conduite sur la seule base de données chiffrées.

Deuxième signe, la vente à découvert, marque de défiance caractérisée, postule que toute l’information utile n’a pas été rendue publique et n’est donc pas intégrée dans le cours de Bourse. Ce signal est d’autant plus crédible que, selon une

Bien entendu, l’exercice de style est facile à faire

Au sein du fatras de la blogosphère et de la twittosphère...

Encore faut-il faire précéder l’analyse du contenu d’une analyse de la source. Selon la société Proxem, spécialiste du web sémantique, « l’analyse de la semaine du 14 septembre 2011 concernant une grande banque française montre que le tweet le plus (ré)émis associe systématiquement le nom de la banque à la chute de l’action et au terme “faillite”. Ces 600 tweets n’ont pas été écrits par des humains, mais réémis en boucle automatiquement par un bot (robot logiciel) qui gère une vingtaine de comptes Twitter. »

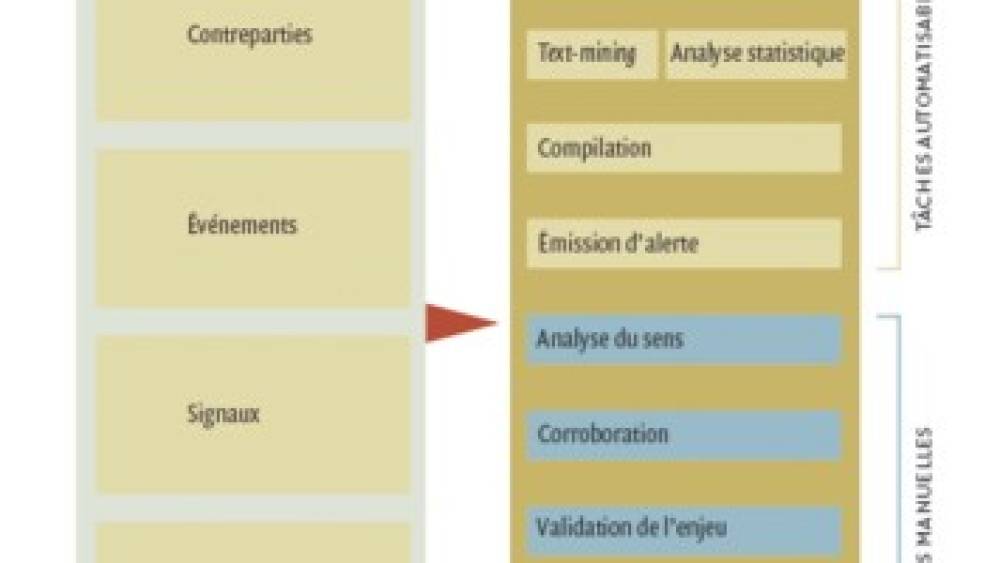

Pour la direction des risques d’un établissement financier, nourrir l’analyse-crédit à partir d’informations hétérogènes et non structurées est un véritable défi. Il s’agit de repérer, au sein du fatras de la blogosphère et de la twittosphère, des signes annonçant une défaillance, d’en identifier la source, d’en analyser le contenu, d’en vérifier la véracité et d’en valider l’enjeu, le tout dans un laps de temps le plus court possible, puisqu’il s’agit de prendre des mesures de sauvegarde avant que la rumeur soit prise en compte par le marché.

On commencera d’abord par définir la liste des contreparties qui feront l’objet d’un suivi sur la Toile. Il faut qu’elles aient de la notoriété, sans laquelle il n’y a ni « buzz » ni informations vérifiables, et qu’elles représentent un enjeu financier.

Une seconde étape du processus consiste à énumérer les types d’événements que l'on cherche à anticiper : on ne s’intéresse pas seulement à l’hypothèse d’une faillite, mais aussi à celle d’une chute soudaine de l’action, d’une publication de

Définir le périmètre des sources à surveiller

Il faut ensuite définir le périmètre des sources à surveiller, un exercice délicat : les institutions financières, les grandes entreprises et les États font l’objet de commentaires directs ou indirects par des centaines de milliers de sources ; celles qui publient sur une cible donnée évoluent dans le temps, certaines s’éteignent ou deviennent moins pertinentes. De nouveaux blogueurs, médias spécialisés, fils de tweets apparaissent chaque jour et émettent des informations ou commentaires sur les contreparties suivies ; enfin, quand un événement se prépare, de nouvelles sources apparaissent, en particulier les « lanceurs d’alerte » : dans le cas de Lehman, le premier signal est révélé par une

Une partie significative du travail, qui devra être automatisée, est de chercher constamment les nouvelles sources qui apparaissent pour une cible donnée, de les identifier, de les qualifier et d’évaluer leur fiabilité. Diverses techniques peuvent être utilisées pour identifier ces sources. On peut en particulier automatiser la recherche dans les moteurs généralistes, pour voir si des sources se mettent à publier des informations portant les signaux recherchés. On peut ensuite, à partir d’une contrepartie faisant l’objet de signaux, chercher dans les réseaux sociaux, comme LinkedIn ou Facebook, des sources qui lui seraient liées, directement ou indirectement, et fourniraient des éléments qui corroboreraient ou, au contraire, invalideraient l’information. On organisera donc, sur la base d’un premier niveau d’identification assisté, à une gestion en continu de la liste des sources, sources généralistes susceptibles de parler de toutes les contreparties, ou sources très spécifiques pouvant apporter des informations sur une seule d'entre elles.

Mise à contribution des logiciels

La recherche des signaux dans les contenus émis par les sources doit être déléguée à des logiciels. Plusieurs types de logiciels peuvent être mis à contribution dans ce dispositif :

- un logiciel de collecte (crawl), pour rapatrier le contenu rédactionnel des pages de blog appartenant à l’univers sélectionné ;

- un logiciel d’analyse de texte, aussi appelé text mining, pour chercher dans ce sous-ensemble une information explicite telle que « nous émettons des réserves sur les comptes publiés par la société X », « M. X est nommé directeur financier de la société Y en remplacement de M. Z », et ce, dans chacune des langues sélectionnées… Ce type de logiciel s’est déjà imposé dans certains secteurs, comme l’édition scientifique et juridique et les sciences de la vie ;

- le couplage de technologies statistiques et linguistiques, pour détecter une augmentation du volume de messages à tonalité négative à propos d’une contrepartie suivie. Le graphique 2 montre ainsi une « analyse de sentiment », sur Société Générale, sur un trimestre,. Jusqu’à présent, cette technique est surtout exploitée dans le cadre de l’analyse d’image, ou d’e-réputation ;

- un logiciel d’analyse de graphe, enfin, pour fouiller dans les réseaux sociaux et y détecter des évolutions de fonctions ou de relations entre personnes liées à des contreparties suivies.

L’intervention des experts

Une fois les signaux identifiés, extraits et formalisés, il s’agit de les rapprocher des autres signaux détectés pour la même contrepartie et le même type d’événement prévisible, de les organiser temporellement, d’identifier leur source et de leur attribuer un degré de pertinence. Il faut également repérer les redondances, les signaux se répétant au gré de leur transmission de source en source.

C’est sur ces bases agrégées, constamment mises à jour, que des algorithmes basés sur des règles et de l’analyse statistique décideront de remonter auprès des responsables du suivi des risques des alertes sur telle ou telle contrepartie, en décrivant le contexte dans lequel elles sont levées.

La part de l’expertise humaine devient à ce stade prépondérante (voir Encadré 3). L’expert doit pouvoir répondre rapidement à plusieurs questions :

- l’information sur un risque de défaillance de la contrepartie est-elle déjà connue et en cours de traitement ?

- émane-t-elle d’une source fiable et indépendante ou peut-elle être le produit d’une manipulation ?

- y a-t-il assez de faits, vrais ou faux, et assez de sources pour que le risque sur la contrepartie soit pris au sérieux par le marché ?

- l’information est-elle basée sur des faits réels ? Si oui, porte-t-elle à conséquence sur la solidité financière de la contrepartie ?

- des spécialistes des médias numériques, pour définir et ajuster quotidiennement le périmètre et les techniques de la fouille ;

- des linguistes, pour modéliser les différentes paraphrases d’un même concept, dans différentes langues ; des analystes, pour traiter les alertes levées ;

- des experts du renseignement, pour identifier l’origine d’informations fausses ou trompeuses ;

- des chargés de communication, enfin, pour diffuser l’information, forcément sensible, auprès des personnes intéressées en interne.

Pour gérer l’information

En cette période où la perception du risque de crédit n’a jamais été aussi vive, et alors que les outils traditionnels que sont les agences de rating et les modèles probabilistes ont montré leurs limites, toute grande institution financière doit s’intéresser à la fois au potentiel d’exploitation de l’information véhiculée par les médias numériques et aux possibilités de traitement de ce matériau offertes par les technologies.