Le thème des données est au cœur de plusieurs réglementations. La gouvernance de la donnée s’impose ainsi comme un des enjeux clés de la mise en conformité.

La donnée, socle commun des obligations réglementaires…

L’actualité réglementaire est toujours aussi riche et la publication le 9 janvier 2013 par le Comité de Bâle du document « Principles for Effective Risk Data Aggregation and Risk

Les grands principes énoncés et développés dans le document associent pour la première fois les finalités poursuivies par la réglementation mais aussi les moyens (infrastructure, gouvernance) dont devraient se doter les acteurs financiers. Cela devient une obligation pour les acteurs les plus importants, les G-

Sur un périmètre européen et sur des sujets aussi variés que MiFID, MAD, EMIR, AML&FT, Bâle 2,5-III, FATCA… un des grands principes, la transparence, oblige les acteurs à collecter, stocker, « reporter » auprès de prestataires de services d’investissement ou organes de régulation, un nombre de données de plus en plus conséquent.

La masse des informations à traiter couvre les données relatives au « client », à des conditions de marché (de prix, d’origine, de source, de comptabilisation, de valorisation), à la création et l’intégration de nouveaux indicateurs (de liquidité, de qualité d’actifs, de fonds propres…).

On notera que des discussions de Place sont en cours pour optimiser et faciliter la gestion de certaines de ces données :

- une certaine standardisation des reportings est recherchée ;

- des acteurs, tel que SWIFT, proposent la fourniture complémentaires de données relatives à leurs clients (« KYC »).

Dans cet objectif, la conformité ne doit pas être perçue comme un objectif de soumission à la réglementation, mais comme une opportunité de créer et de nourrir une intelligence organisationnelle de la chose réglementaire : « ce n’est pas la conformité mécanique qui est une source d’amélioration de la performance, mais la qualité du mode organisationnel de la

…au niveau macro- et micro-économique

À un niveau « macroéconomique », la BCE en tant que nouvel et unique régulateur bancaire européen doit avoir une vision juste et exhaustive du domaine d’activité dont elle a la supervision. L’objectif qui lui a été fixé peut passer par :

- la mise en place d’une certaine « standardisation » des données (pouvoir comparer ce qui est comparable) ;

- le respect des principes bâlois dont l’application lui permettra d’avoir cette qualité de vision.

À un niveau micro-économique, au niveau de chacun des établissements, une bonne gouvernance des données doit permettre l’amélioration des processus, une analyse plus pertinente et efficace des risques encourus, de leur juste appréciation. Le cas échéant, l’établissement pourra prendre alors les mesures correctives souhaitées et/ou qui s’imposent à lui (voir Figure 1).

La gouvernance des données

Les approches concourant à la standardisation et à la fiabilisation des données sont multiples :

analyse sémantique et modélisation des objets métiers, master data management et dictionnaires de données, pilotage de la transformation des données, analyse des impacts et traçabilité fonctionnelle, mise en place de pistes d’audit, processus de contrôles et de traitement des anomalies… Mais ces pratiques autour du management de la donnée restent souvent confinées aux seuls professionnels des SI.

Dans le contexte fortement cloisonné des filières risques, finances et SI, ces démarches de management de la donnée lorsqu’elles dépassent le domaine IT, se traduisent par des initiatives éparses, en silos. Face à l’importance des enjeux et l’ampleur des chantiers Données en réponse aux exigences réglementaires, il est nécessaire en amont du management de la donnée, de mettre en place une véritable gouvernance globale des données.

L’objectif est de faire de ces actions de gestion de la donnée des actes stratégiques à la hauteur des enjeux :

- définir une véritable stratégie Données ;

- en partager les enjeux et les objectifs ;

- décider des niveaux de risques acceptables ;

- fixer ensemble les orientations, investir sur des initiatives Données ciblées et porteuses de valeur pour la banque ;

- définir les modalités de suivi de la performance et de la conformité ;

- par ailleurs, sensibiliser les acteurs sur l’ensemble de la chaîne de l’agrégation, en promouvant une culture « Qualité des données » indissociable de la culture « Risques ».

- connaître les données ;

- savoir les représenter ;

- les porter dans l’organisation ;

- les enrichir de services ;

- intégrer les nouveaux modèles économiques.

Connaître les données

La donnée engage la banque. Elle est générée ou « consommée » par des processus, « partagée » au sein de l’établissement voire à l’échelle internationale. Il faut donc parfaitement la connaître, la maîtriser :

- connaître et partager son sens, sa définition pour l’ensemble des parties prenantes, dans le cadre d’une analyse sémantique ;

- connaître et partager le niveau de qualité attendu des différents métiers (sa qualité intrinsèque et la qualité liée à son contexte d’

utilisation ;[5]) - connaître les règles de sécurité et d’accessibilité qui s’y appliquent, le contexte

réglementaire ;[6] - savoir où elle prend

naissance , où elle est stockée avec quel niveau de fiabilité et d’exhaustivité.[7]

La gouvernance des données actera au plus haut niveau qui sont les propriétaires de ces données et quels sont les droits et devoirs de chacun des acteurs à leur sujet.

Savoir les représenter

Pour livrer toute sa valeur, cet inventaire doit être partagé et évolutif. Il doit s’inscrire dans le patrimoine de connaissance de la banque (directives stratégiques, processus et procédures, parc applicatif et technique, …). Il faut donc savoir représenter les données de manière compréhensible par tous. Les représentations les plus élémentaires des données sont les lexiques ou dictionnaires listant pour chacune des données, définition, termes associés, sources, propriétaires… Il peut également être intéressant de les cartographier. Ces représentations peuvent aussi être portées par les démarches d’urbanisation des

D’autres types de représentations existent telles que les cartes heuristiques (ou cartes mentales, cartes des idées) qui permettent de représenter visuellement le cheminement associatif de la pensée autour de la donnée.

Le choix des méthodes de représentation est un choix d’entreprise, car elles instaurent un langage commun et sont déterminantes pour la communication autour des données. Loin d’être anodin, ce choix doit être fait en transverse et non imposé par l’IT, un formalisme accessible favorisera le partage et l’investissement des métiers et au final la qualité de la donnée.

Les porter dans l’organisation

Une fois la donnée connue, ses usages identifiés et sa représentation actée, se pose la question de la « portée » de sa connaissance et de sa maîtrise. Tout d’abord en termes d’organisation : la banque doit s’organiser autour de la donnée de manière à sensibiliser les différents acteurs,promouvoir la culture « donnée », mettre en place les instances qui portent cette mission. La culture de la donnée ne doit pas rester confinée à un public d’initiés.

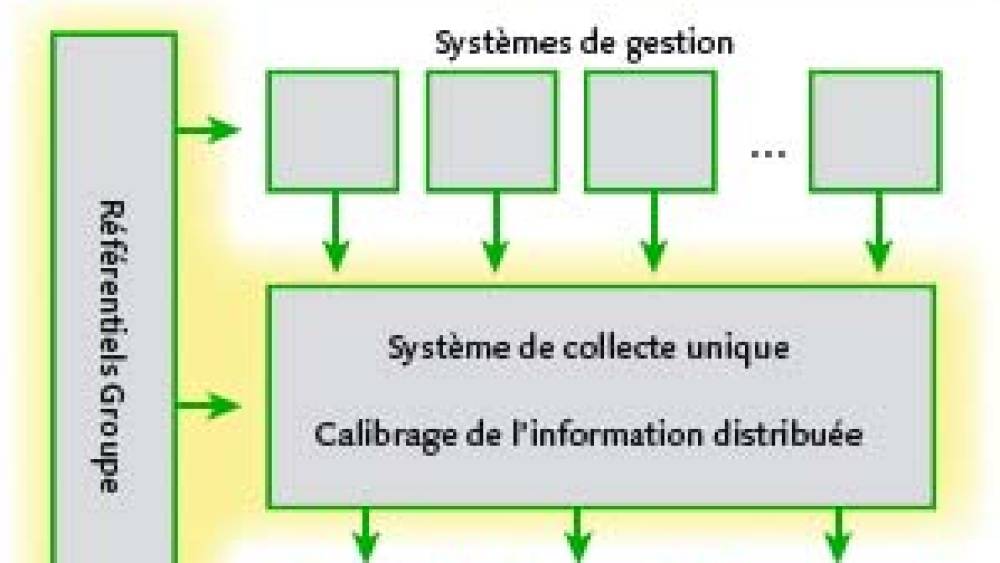

Depuis quelques années, plusieurs voix s’élèvent pour promouvoir un système de collecte unique plaidant en faveur de la convergence des référentiels comptables et des référentiels risques (avec l’exemple notamment de la « perte estimée »). En faisant l’apologie d’une base unique alimentée par les différents systèmes de gestion et à la granularité suffisamment fine pour alimenter à son tour les systèmes risques, financier et trésorerie, ces voix expriment le besoin d’une organisation transverse fédérant les différents métiers et porteuse de l’expertise Données traditionnellement cantonnée aux DSI. L’enjeu est de dépasser les clivages organisationnels au profit de la fiabilité, de la réactivité, de l’efficience des processus de chacun, de la réduction des coûts globaux (voir Figure 3).

Pour « porter » les données, plusieurs types d’organisations sont possibles allant du processus intégré autour d’un centre de compétences centralisé et dirigé par un membre du COMEX justifiant toutes décisions importantes, au choix d’une organisation éclatée, répartie sur différents métiers ou entités et animée autour d’un réseau de compétences favorisant la parfaite connaissance de l’environnement. L’essentiel : que les acteurs impliqués soient représentatifs des différentes perspectives sur la donnée (métiers, géographiques… et regroupant idéalement les compétences et visions risques et IT).

En termes de communication et de conduite du changement, un « portail DATA » accessible sur le réseau interne de l’établissement et regroupant à la fois la connaissance sur les données et l’accès à certaines d’entre elles (données de référence, données publiques…) peut-être un bon support pour décloisonner les silos existants.

La gouvernance permettra de définir le cadre d’organisation et de communication autour des données et le faire vivre : processus et instances transverses de validation et de gestion de la donnée entre « propriétaires », « consommateurs », « architectes IT »… et de partager les exigences et contraintes qui s’y appliquent.

Enrichir les données de services

La pertinence de l’analytique demande d’alimenter un système homogène. Or plus le SI est cloisonné composé de couches superposées historiquement et hétérogènes, plus cela devient difficile. Les données ne sont pas rangées à l’identique, ne remontent pas de façon comparable, n’ont pas la même signification, d’où les problèmes d’exploitation et d’interprétation.

Grâce à la connaissance des données et ses représentations, l’organisation mise en place autour de la donnée permettra de définir des priorités et des responsabilités. Elles feront émerger les données dites référentielles, c'est-à-dire reconnues comme références sur les sujets traités, et dont le partage est structurant pour l’établissement.

Dans un contexte fortement évolutif, l’anticipation est la règle. Apporter, par construction l’agilité et la réactivité, doit permettre de capitaliser (ne plus « courir » après la collecte des données à chaque nouvelle réglementation). La donnée doit s’enrichir de « services » et répondre ainsi à plusieurs contextes d’utilisation. Cette offre de services pourra s’appuyer sur :

- l’acquisition pilotée de données externes (centralisation des acquisitions, publication et diffusion des dernières mises jours, par exemple via le portail DATA précédemment cité) ;

- des

référentiels , garantissant la disponibilité en un point unique et partagé d’une donnée de qualité à forte plus-value (exemples : référentiel Structures, Clients, Tiers, Activités, Produits, Notations) ;[9] - du data mapping, permettant d’harmoniser les échanges de données entre plusieurs métiers ou applications et de réutiliser leurs formats, de traduire les spécificités liées à l’usage qu’en font les métiers (exemple : pivot d’échanges entre les transactions financières) ;

- des socles de données regroupant toutes les données précédemment identifiées au sein d’un même entrepôt de données et accessibles indépendamment des contraintes opérationnelles des applications. Ces socles offrent des « points de vérités » et une granularité plus fine que les systèmes de Business Intelligence qui procèdent sur des agrégats. Les besoins en décisionnel, contrôle qualité, visualisation des données, publications et reportings viennent se nourrir de ces socles ;

- les ateliers de manipulation de données (exemple : « DATALAB ») sont une réponse innovante en matière d’exploitation de données issues d’origine multiples. Ils combinent les socles de données aux référentiels, aux apports de données externes et à la connaissance des données existantes. Ils en permettent la manipulation, dans une logique « bac à sable », aux acteurs Risques pour des analyses sur les données en prévisions d’études (protection des données et statistiques pour appréhender le profil risque d’un client ou d’une contrepartie ; stress testing pour tester la résilience des banques). Ces « DATALAB » pallient en grande partie le schéma classique du « no data intégration » que rencontre la filière Risques où, lors d’une nouvelle réglementation, le SI Risques n’intègre pas la donnée utile du SI de gestion ou la donnée n’existe pas encore dans le SI de la banque.

Plusieurs approches sont possibles dans la mise en place de ces services (de la table rase de l’existant au schéma directeur pluriannuel d’amélioration). La principale recommandation étant de ne pas se lancer dans des programmes longs et coûteux, mais plutôt dans des initiatives innovantes et représentatives autour de périmètres priorisés grâce à la connaissance des données.

La gouvernance permettra de prioriser et de piloter la mise en place de ces différents services dans une logique de gain de productivité, d’agilité et de meilleure maîtrise des risques.

Intégrer les nouveaux modèles économiques

Enfin le dernier pilier concerne le choix des modèles économiques autour de la donnée. Les enjeux, les risques et l’impact sur le business model existant sont les suivants :

- augmenter la valeur de ses donnéesen injectant des données externes (exemple de la lutte contre le blanchiment et le financement du terrorisme), en maîtriser les risques induits (au plan de la sécurité, de la fiabilité, de la disponibilité…) ;

- élargir l’offre. À l’heure du numérique et de la banque digitale, la maîtrise de ses données permet à la banque de se préparer au Big Data en enrichissant son patrimoine informationnel et en offrant la transparence attendue ;

- optimiser ses infrastructures IT pour réduire les coûts. Les acteurs SI (architectes et responsables de la sécurité SI) sauront conseiller les métiers sur les modèles opportuns pour la banque (exemple du « Data As A Service », une déclinaison de l’alternative Cloud pour accéder à un dépôt de données externes via une interface fournie par un tiers).

La gouvernance guidera le choix des business models en matière de données, et fixera au plus haut niveau les attendus, les limites et leurs impacts en termes d’organisation, les contrôles…

Créer une dynamique commune

Au-delà du caractère transverse de ces initiatives Données, leur ampleur et leur diversité sont sources de difficultés. Elles demandent à être priorisées et objectivées. Pour leur mise en œuvre, un programme s’impose, sans lequel le dispositif mis en place manquerait d’une feuille de route. Ce programme « Gouvernance des données & Conformité », porteur des objectifs et des ambitions Données, en fixera les grandes échéances, et permettra de fédérer les filières autour une dynamique commune. Son succès demande à ce qu’il ait le plus fort ancrage aux projets existants.

Les comités en charge de la gouvernance des Données en feront un suivi régulier et communiqueront sur ses bénéfices tangibles. Ils pourront ainsi inscrire la qualité des données dans un cercle vertueux. Missionnés sur la montée en maturité de la banque en matière de qualité des données, à chacun des niveaux de son organisation, ils interviendront dans la résolution des conflits lorsque les politiques des différentes entités divergeront ou mettront en péril la recherche de synergies.

Certains établissements financiers, convaincus du rôle joué par la rationalisation des SI dans l’amélioration de leurs capacités d’agrégation, ont déjà mis en place de tels programmes orientés Données. Les cinq piliers devraient y être explicites pour décider des modalités de mise en œuvre, au plus haut niveau, conjointement entre fonctions Risques, Finances et SI.

Pour pérenniser la maîtrise de ces enjeux autour de la donnée, des établissements ont déjà fait le choix de créer une fonction ad hoc : le Chief Data Officer ou directeur des données, devient l’autorité responsable de la coordination autour de la donnée, de sa qualité et de la cohérence de l’information. Fonction dirigeante et transverse, il porte les programmes « Gouvernance des données & Conformité » et la communication autour de la valeur de la donnée pour l’établissement.